Souvent, entre vieux de la vieille d’Openweb, on se dit que c’était mieux avant. Et puis, à l’ombre de nos marronniers, sur notre petit banc, il y a toujours quelqu’un pour dire que non, c’est normal, c’est la nostalgie, ça, les gars et les filles. Le monde change et c’est la vie.

Alors voilà, je suis sans doute un vieux con, mais moi j’aime bien arriver sur une page web, un truc qui est construit avec du HTML, et lire la page, dans laquelle se trouve un contenu qui est construit avec du HTML, brique fondamentale du Web.

Mais, a priori, Google s’en fout comme de son premier million de dollars, des vieux cons comme moi qui espèrent naïvement lire une page web en cliquant sur une URL. On peut crever la gueule ouverte, on n’a qu’à continuer à faire notre petit web perso tout pourri avec nos petits CMS tout pourris, hein. On dérange personne, et en particulier ceux qui se goinfrent de fric avec les données personnelles de leurs visiteurs.

Une page vide

Voilà ce qui m’agace, cet après-midi. Je vais visiter un article du blog Chromium [1], et là j’ai une page vide.

Ah flûte, me dis-je, voilà que ma vile paranoïa qui m’a conditionné à toujours installer sur mon Firefox uBlock Origin et Privacy Badger me joue des tours. Ciel, me dis-je encore, ce blog doit être codé avec les pieds et attendre que tel ou tel script soit chargé, au lieu de faire du beau développement asynchrone comme savent le faire les bons développeurs web que j’ai la chance de compter parmi mes copains.

Je lance donc une session privée de Firefox, j’y colle l’URL, je désactive uBlock Origin et Privacy Badger. Tu vois comme j’ai envie de lire ton article, hein.

Et là toujours rien.

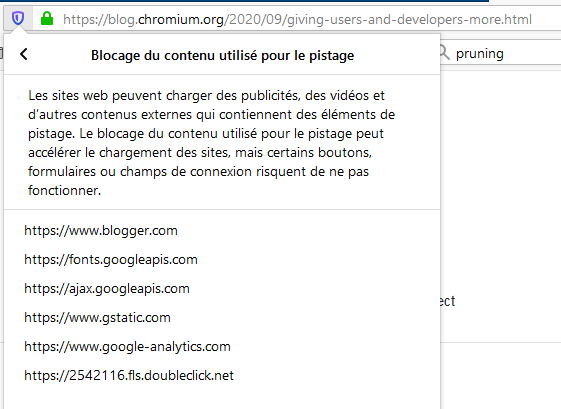

Ah oui, j’ai aussi les « Protections renforcées contre le pistage ». C’est une fonction native de Firefox, il va falloir commencer à y penser quand tu fais tes tests. Alors je les désactive aussi, après avoir regardé quels domaines tiers ont été sollicités.

Bon, je désactive aussi la protection renforcée. Comme vous le voyez ci-dessus, le domaine que j’essaie d’afficher est blog.chromium.org et il n’est pas bloqué par Firefox (sans quoi je ne verrais pas la page du tout).

Alors oui, ah là, le contenu s’affiche. Chic alors.

Je décide de revenir à ma configuration de base, et d’afficher le contenu sans CSS : parfois il y a juste un script tout pourri pour frimer avec un petit indicateur de chargement, le temps qu’on agrège des trucs et des machins, mais quand on désactive les CSS on voit que le contenu est déjà là.

Ici non, rien. Buvons le calice du Web moderne jusqu’à la lie.

Bref, en résumé :

- ce site ne peut pas s’afficher si on bloque les services tiers ;

- ce site ne comporte même pas de contenu si on bloque les services tiers ;

- ce site affiche quand même le logo Google parce que bon.

Gymnastique du Web moderne

Donc si, de nos jours, on veut lire un article sur ce blog, il faut soit accepter de se balader à poil et d’offrir ses données privées à plein de gens (voir ci-dessus), soit passer par une gymnastique amusante, par exemple :

- ouvrir l’article,

- constater que oulàlà c’est tout vide,

- ajouter l’article à wallabag (ou autre lecteur hors ligne peut-être, je n’ai que celui-là à vous conseiller qui me comble d’aise),

- lire l’article dans l’application wallabag.

Dans wallabag j’en profite pour constater que la sémantique HTML de l’article est bien pauvre, mais bon, on s’en fout hein. La sémantique HTML, c’est comme l’accessibilité : on se demande bien qui en a besoin.

J’ai pris l’article du blog Chromium parce que c’est une fois de trop, mais si vous saviez le nombre de trucs aussi mal fichus que je vois tous les jours. Disons-le bien fort au cas où ce ne serait pas clair : une page de blog n’est pas une application Web qui demande une interaction forte.

Alors ouais, je vais continuer à aller lire les petits sites pourris perso des copains, parce que eux, au moins, respectent leurs lecteurs et leurs lectrices.